IA et éthique en Europe : que prévoit la proposition de règlement l’AI Act ?

Article publié le 24 mai 2023

L’AI Act, c’est quoi ?

L’AI Act est une proposition de règlement communautaire qui a pour objectif d’encadrer le développement, l’usage et la commercialisation de solutions d’IA afin de préserver la sécurité et les droits des utilisateurs. Il s’agit ainsi d’instaurer en Europe un IA de confiance, respectueuse des droits fondamentaux.

Pour cela, cette proposition prévoit d’une part de classifier les usages à risque des IA, dans des domaines tels que l’éducation, les ressources humaines, le maintien de l’ordre ou le contrôle aux frontières, et d’autre part, d’imposer aux entreprises des contrôles plus stricts.

- S’assurer d’un contrôle humain

L’AI Act vise à instaurer, au sein de chaque Etat membre, un organe de contrôle afin de s’assurer que les entreprises qui développent des solutions d’IA garantissent un contrôle humain, mettent en place une documentation technique et instaurent un système de gestion des risques.

- Interdiction de certains usages

La proposition de règlement prévoit également l’interdiction de certaines applications telles que la reconnaissance faciale dans l’espace public ou encore les outils de police prédictive.

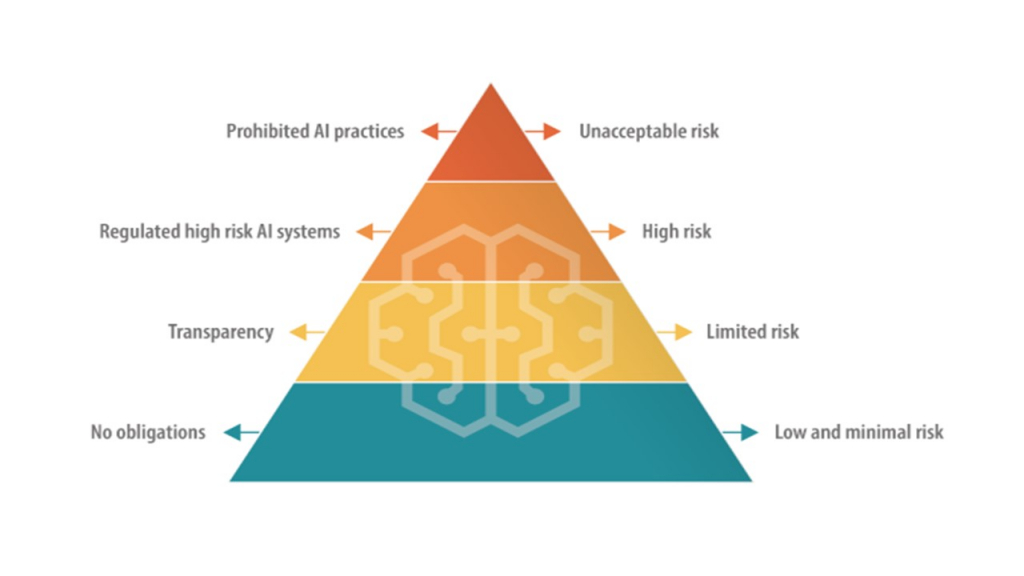

- Classification des IA en fonction du risque

Concernant les IA génératives, telles que ChatGPT, elle prévoit d’instaurer quatre niveaux de risque :

– Risque inacceptable : C’est le niveau de risque maximal, contraire aux droits fondamentaux de l’Union européenne. Sont ici visés, les systèmes d’IA qui exploiteraient les vulnérabilités de certains groupes de personnes, les systèmes d’identification biométrique à distance, les systèmes de « social scoring »/évaluation des personnes physiques et enfin les systèmes présentant un risque de préjudice pour la santé physique et psychologiques.

– Haut risque : Concerne les systèmes qui, compte tenu du risque d’erreur qu’ils impliquent, devront être évalués par de agences nationales avant d’être mises sur le marché. Il s’agit par exemple de systèmes de gestion d’infrastructures critiques (telles que les centrales électriques), de systèmes qui touchent à l’éduction ou encore au droit.

– Risque moyen : Pour cette catégorie, l’exploitant du système devra satisfaire à une obligation de transparence et expliquer le fonctionnement de son système.

– Risque faible : Concerne les systèmes autorisés comme les objets connectés utilisés dans la vie quotidienne (montre connectée…) qui ne seront pas soumis à une autorisation préalable.

Les développeurs de ce ces solutions de ce type seront ainsi, selon le niveau de risque de leurs systèmes, dans l’obligation de respecter les obligations de transparence prévues dans le règlement.

- Quel calendrier ?

Les eurodéputés, qui étaient parvenus à un premier accord le 11 mai dernier, ont majoritairement adopté le texte en plénière le 14 juin 2023. S’en suit une phase de négociations entre le conseil de l’Europe et la Commission européenne pour une entrée en application en 2026.

DIVA, c’est quoi ?

En Pays de la Loire, l’EDIH DIVA est un collectif d’experts du numérique, de l’innovation et du développement économique qui œuvre pour permettre aux entreprises ligériennes d’accélérer leur transformation digitale tout en développant des usages utiles et éthiques de la donnée par les entreprises.

Vous vous questionnez sur les sujets de la DATA et de l’IA ? Vous vous demandez si ces sujets vous concernent ? Vous souhaitez vous faire accompagner dans votre projet ? Contactez-nous !

Pour en savoir plus sur l’AI Act : https://artificialintelligenceact.eu/